Trong bối cảnh dữ liệu trở thành tài sản chiến lược, nhiều doanh nghiệp đang gặp phải những khó khăn lớn trong việc quản lý và khai thác giá trị từ dữ liệu. Thiếu một hệ thống xử lý và quản lý hiệu quả có thể dẫn đến sai lệch trong phân tích, ra quyết định thiếu chính xác, và giảm hiệu quả hoạt động kinh doanh. Dưới đây là 5 vấn đề chính mà các doanh nghiệp thường đối mặt khi quản lý dữ liệu của mình:

- Dữ liệu phân tán và không nhất quán: Dữ liệu được lưu trữ trên nhiều hệ thống khác nhau, gây khó khăn trong việc tập trung và đồng bộ hóa. Việc thiếu một kho dữ liệu thống nhất khiến việc phân tích và ra quyết định trở nên phức tạp và thiếu chính xác.

- Chất lượng dữ liệu kém: Dữ liệu thô thường chứa nhiều lỗi, trùng lặp hoặc thiếu thông tin. Điều này dẫn đến việc phân tích sai lệch và ra quyết định không chính xác, ảnh hưởng tiêu cực đến hoạt động kinh doanh.

- Thiếu khả năng phân tích theo thời gian thực: Nhiều doanh nghiệp gặp khó khăn trong việc thu thập và xử lý dữ liệu kịp thời. Họ phải dựa vào các báo cáo lỗi thời, không thể phản ứng nhanh chóng với những thay đổi trong thị trường hoặc tình hình kinh doanh.

- Khó khăn trong việc áp dụng AI và Machine Learning: Dù đã thu thập nhiều dữ liệu, doanh nghiệp vẫn thiếu công cụ và nền tảng phù hợp để áp dụng các thuật toán AI, phân tích dự đoán và tối ưu hóa dữ liệu để tạo ra giá trị cao hơn.

- Khó khăn trong việc trực quan hóa dữ liệu: Dữ liệu phức tạp và lớn khiến cho việc chuyển đổi thành các báo cáo trực quan, dễ hiểu trở nên khó khăn. Điều này hạn chế khả năng tiếp cận thông tin của các nhà quản lý và ảnh hưởng đến việc ra quyết định chiến lược.

Mô tả giải pháp

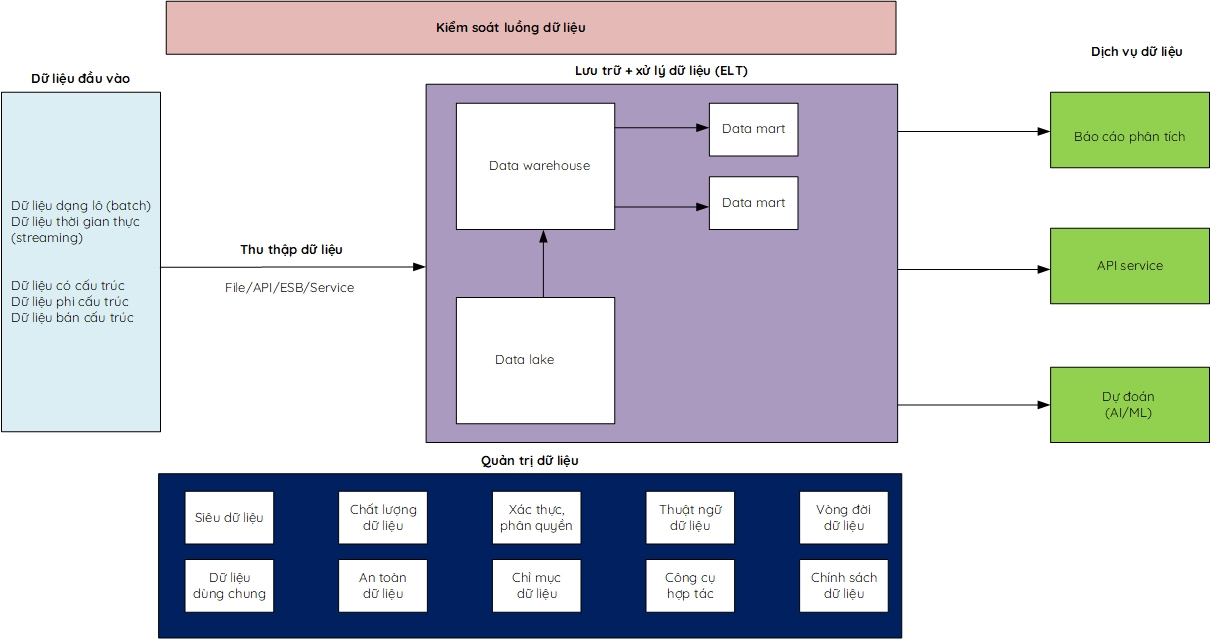

Giải pháp quản lý và khai thác dữ liệu của chúng tôi bao gồm các thành phần chính phục vụ cho việc tích hợp, lưu trữ, xử lý và phân tích dữ liệu từ nhiều nguồn khác nhau. Data integration cho phép thu thập dữ liệu đầu vào dưới cả hai dạng lô (batch) và thời gian thực (streaming). Các kiểu dữ liệu bao gồm dữ liệu có cấu trúc, phi cấu trúc và bán cấu trúc.

Sau khi dữ liệu được tích hợp, nó sẽ được lưu trữ tại kho dữ liệu tập trung, tùy thuộc vào yêu cầu cụ thể của dữ liệu đầu vào mà có thể sử dụng hệ thống Big Data (Hadoop) hoặc Datawarehouse (PostgreSQL). Dữ liệu được lấy thông qua các phương thức kết nối linh hoạt như nhận file, API, dịch vụ cơ sở dữ liệu (Database Service), hoặc qua trục dữ liệu doanh nghiệp (Enterprise Service Bus – ESB). Công cụ tích hợp dữ liệu chính bao gồm Apache Nifi và Apache Kafka, giúp đảm bảo quá trình truyền dữ liệu ổn định và chính xác.

Dữ liệu lưu trữ tại kho sẽ trải qua quá trình làm sạch, chuẩn hóa và chuyển đổi (nếu cần thiết) sử dụng Dbt (Data Build Tool). Sau khi được xử lý, dữ liệu sẽ được đưa ra Data Mart để làm đầu vào cho các công cụ trực quan hóa dữ liệu như Power BI hoặc Tableau, giúp cung cấp các báo cáo và phân tích dữ liệu rõ ràng, dễ hiểu. Một phần dữ liệu có thể được chia sẻ qua cổng dữ liệu mở (CKAN), giúp doanh nghiệp dễ dàng cung cấp và chia sẻ thông tin với các bên liên quan.

Ngoài ra, dữ liệu thô hoặc đã qua xử lý có thể được sử dụng làm đầu vào cho các mô hình AI nhằm mục đích phân tích sâu dữ liệu lịch sử hoặc dự đoán xu hướng tương lai. Để đảm bảo tính bảo mật và quản lý dữ liệu hiệu quả, các công cụ quản trị dữ liệu được áp dụng để quản lý các chỉ mục dữ liệu (Data Catalog), siêu dữ liệu (Metadata), chất lượng dữ liệu (Data Quality), xác thực và phân quyền tập trung, thuật ngữ dữ liệu (Glossary), vòng đời dữ liệu (Data Lineage), an toàn dữ liệu theo các chính sách rõ ràng. Công cụ này còn hỗ trợ việc hợp tác khai thác dữ liệu giữa các bộ phận trong doanh nghiệp, đảm bảo mọi quy trình liên quan đến dữ liệu đều tuân thủ các quy định an toàn và chính sách bảo mật.

Ưu điểm giải pháp

Chuyên gia triển khai

Khách hàng

Công nghệ

Số dự án

Kiến trúc dịch vụ

Tích hợp dữ liệu (Data Integration):

- Hỗ trợ nhiều nguồn dữ liệu: Cho phép tích hợp dữ liệu từ các nguồn đa dạng như hệ thống ERP, CRM, cơ sở dữ liệu, API và file.

- Kết hợp xử lý batch và streaming: Hỗ trợ cả xử lý dữ liệu theo lô (batch) và thời gian thực (streaming) để đáp ứng các nhu cầu khác nhau của doanh nghiệp.

- Công cụ mạnh mẽ: Sử dụng các công cụ chuẩn ngành như Apache Nifi và Apache Kafka để đảm bảo tích hợp dữ liệu mượt mà, ổn định và có khả năng mở rộng.

Lưu trữ dữ liệu (Data Storage):

- Linh hoạt về công nghệ lưu trữ: Hỗ trợ cả kho dữ liệu lớn (Big Data) trên Hadoop và kho dữ liệu quan hệ (Data Warehouse) trên PostgreSQL tùy theo yêu cầu cụ thể.

- Tối ưu hóa chi phí và hiệu năng: Đảm bảo lưu trữ hiệu quả, tối ưu chi phí mà vẫn đáp ứng được nhu cầu về hiệu năng của doanh nghiệp.

- Bảo mật dữ liệu: Hệ thống lưu trữ tích hợp các lớp bảo mật cao để bảo vệ dữ liệu trước các mối đe dọa từ bên ngoài cũng như quản lý quyền truy cập nội bộ.

Chuyển đổi dữ liệu (Data Transformation):

- Làm sạch và chuẩn hóa dữ liệu: Thực hiện làm sạch dữ liệu thô, loại bỏ dữ liệu trùng lặp hoặc lỗi, đảm bảo dữ liệu được chuẩn hóa để phân tích hiệu quả.

- ELT (Extract, Load, Transform): Áp dụng phương pháp ELT để trích xuất, nạp và chuyển đổi dữ liệu, giúp quy trình linh hoạt hơn so với phương pháp truyền thống.

- Công cụ mạnh mẽ như Dbt: Sử dụng Dbt (Data Build Tool) để tự động hóa quy trình chuyển đổi và tối ưu hóa dữ liệu cho các ứng dụng phân tích và báo cáo.

Cổng dữ liệu mở (Open Data Portal):

- Quản lý và xuất bản dữ liệu: CKAN cung cấp tính năng quản lý dữ liệu toàn diện, cho phép các tổ chức xuất bản, lưu trữ, và chia sẻ dữ liệu mở một cách dễ dàng. Các bộ dữ liệu có thể được tổ chức theo chủ đề, định dạng, và nguồn gốc, giúp người dùng tìm kiếm và truy cập nhanh chóng. CKAN hỗ trợ nhiều định dạng dữ liệu khác nhau như CSV, JSON, XML.

- API mạnh mẽ và khả năng tích hợp: CKAN đi kèm với API mở cho phép các nhà phát triển truy cập, tìm kiếm và sử dụng dữ liệu một cách tự động. Điều này giúp dễ dàng tích hợp CKAN với các hệ thống dữ liệu khác hoặc xây dựng các ứng dụng dựa trên dữ liệu. Ngoài ra, API hỗ trợ cả việc tải dữ liệu lên và lấy dữ liệu xuống, mở rộng khả năng sử dụng của nền tảng.

- Tính năng phân tích và trực quan hóa dữ liệu: CKAN có khả năng tích hợp với các công cụ trực quan hóa dữ liệu như DataStore hoặc tích hợp với các công cụ phân tích bên ngoài. Người dùng có thể tạo các bảng điều khiển, biểu đồ và báo cáo từ các tập dữ liệu trực tiếp trên nền tảng, giúp việc khai thác dữ liệu trở nên dễ dàng và hữu ích hơn trong việc đưa ra các quyết định chiến lược.

Trực quan hóa dữ liệu (Data Visualization):

- Công cụ mạnh mẽ: Tích hợp các công cụ trực quan hóa dữ liệu như Power BI, Tableau giúp người dùng dễ dàng tạo các báo cáo tương tác và biểu đồ phân tích.

- Báo cáo thời gian thực: Hỗ trợ tạo các báo cáo trực quan với dữ liệu thời gian thực, giúp người dùng đưa ra quyết định kịp thời và chính xác.

- Tùy chỉnh theo nhu cầu: Các bảng điều khiển (dashboard) và báo cáo có thể tùy chỉnh linh hoạt để phù hợp với các yêu cầu kinh doanh cụ thể.

Quản trị dữ liệu (Data Governance):

- Quản lý chỉ mục dữ liệu (Data Catalog): Cung cấp một kho lưu trữ trung tâm cho tất cả dữ liệu trong doanh nghiệp, giúp dễ dàng tra cứu, quản lý và truy cập. Data Catalog giúp người dùng tìm kiếm nhanh chóng và hiểu rõ về dữ liệu hiện có, đồng thời đảm bảo dữ liệu được tổ chức hợp lý và dễ tiếp cận.

- Quản lý siêu dữ liệu (Metadata Management): Siêu dữ liệu cung cấp thông tin chi tiết về thuộc tính, nguồn gốc và quá trình biến đổi của dữ liệu. Quản lý siêu dữ liệu đảm bảo tính minh bạch của dữ liệu, giúp người dùng hiểu rõ bản chất và lịch sử của các tập dữ liệu.

- Đảm bảo chất lượng dữ liệu (Data Quality): Đưa ra các tiêu chuẩn để đánh giá và cải thiện chất lượng dữ liệu. Các công cụ giám sát giúp phát hiện và sửa chữa các lỗi về tính toàn vẹn, độ chính xác và tính nhất quán của dữ liệu, đảm bảo dữ liệu đáng tin cậy và phù hợp với các quyết định kinh doanh.

- Xác thực và phân quyền tập trung: Quản lý quyền truy cập dữ liệu, chỉ cho phép người dùng được ủy quyền truy cập vào các loại dữ liệu nhất định. Điều này tăng cường bảo mật và đảm bảo tuân thủ các quy định về an toàn dữ liệu, đồng thời hạn chế truy cập không mong muốn.

- Thuật ngữ dữ liệu (Data Glossary): Định nghĩa và tiêu chuẩn hóa các thuật ngữ liên quan đến dữ liệu trong toàn doanh nghiệp, giúp mọi người sử dụng các thuật ngữ nhất quán. Data Glossary đảm bảo rằng tất cả các thành viên đều có sự hiểu biết chung về các thuật ngữ dữ liệu mà họ đang làm việc.

- Vòng đời dữ liệu (Data Lineage): Theo dõi toàn bộ hành trình của dữ liệu, từ khi được thu thập đến khi xử lý và sử dụng. Data Lineage giúp người dùng theo dõi nguồn gốc và các thay đổi của dữ liệu, đồng thời cung cấp khả năng giám sát và phân tích quy trình quản lý dữ liệu.

- An toàn dữ liệu và tuân thủ chính sách: Đảm bảo dữ liệu được bảo vệ thông qua các chính sách bảo mật nghiêm ngặt, giúp doanh nghiệp tuân thủ các quy định pháp lý và đảm bảo an toàn cho dữ liệu quan trọng.

- Hợp tác khai thác dữ liệu: Công cụ quản trị dữ liệu còn hỗ trợ hợp tác khai thác dữ liệu, cho phép các phòng ban và đối tác trong doanh nghiệp cùng chia sẻ và phân tích dữ liệu một cách hiệu quả, đảm bảo mọi thông tin được khai thác tối đa và hỗ trợ các quyết định kinh doanh chiến lược.